| 摘要:气流管理的考虑将告诉我们如何利用我们卓越的气流管理实践来降低数据中心的运营成本。 |

气流管理的考虑将告诉我们如何利用我们卓越的气流管理实践来降低数据中心的运营成本。

在系列早前的文章中,已经向大家证实了数据中心运行在提高服务器风扇能耗降低能耗之前,在服务器性能受到不利影响之前,在服务器价格增长,提高运营费用之前,可以比传统数据中心建议的运行温度要高。

紧接着,建议无冷水机组的数据中心比传统的数据中心更加显示,并且,通过证据显示,由OEM厂商提供的ICT设备通常允许比主流标准和行业准则更宽的湿度范围。

本系列的前5个部分提供了来自制造商产品信息、独立实验室研究结果和数学模型的证据,这些信息结合在一起,向我们对设计、建造和操作数据中心的有效性提出了一个十分有利的证明——现在完全有条件建立、运行没有冷水机组或制冷剂冷却的数据中心。今天我们在充满争议的环境中,研究一下ICT设备的可靠性。

很明显,在有了一些温度限制之后,服务器的故障率开始上升,另外,为什么所有的制造商出具的用户文档以及各类行业推出的标准都对设备的进风温度做出了最高、最低的限制呢?

随着时间的推移,这些指南的范围已经扩大, 我们不禁想到,当ASHRAE TC9.9首次创建一个允许的温度限制类别时,短时间内的定义可能是什么:是以分钟?小时?天数为单位?这样做是否会产生灾难性的崩溃或加速一些计划故障率呢?

早在六年前,我已经得到了答案,但出于某种原因,这些答案对于我而言,还不算是重大的突破,只是前进路上又进了一小步。这一突破是ASHRAE TC9.IT小组委员会中的19家的ICT 的OEM厂商向我们揭开答案。

设计,建造和维修ICT设备业务的每个人都具有从设备故障保修经验中获得的某些数据库,其中大部分数据包括有关故障条件(包括温度)的内部足迹。

对于那些公开的数据信息的人来,似乎不太谨慎,他们对此会做出半公开的信息——在L平台运行的18个月的时间里,服务器有14%的故障率,运行温度在90˚F(32℃)的时候,运行时间超过30%。

他们进一步透露出的信息是,在68˚F(20℃)时,他们的设备会遇到某种位置的故障率,他们的常规客户群将能够从经验中脱颖而出,然后他们可以分享他们在特定温度低于68˚ F的实际体验,他们的设备可能会有90%故障率,而在某些特定温度高于68˚F的情况下,他们的设备可能会以1.15%的故障率,或其他任何历史显示失败。

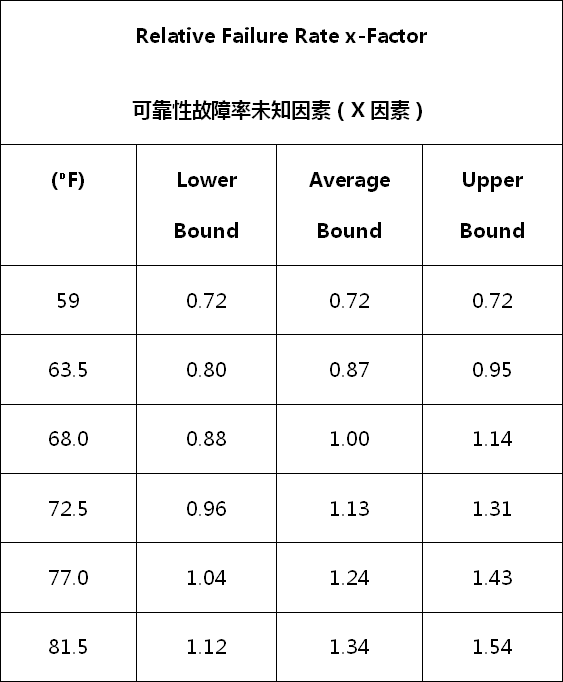

下面的表1总结了这一练习的结果,其中基线被确定为68 f的预测设备故障,与高于平均服务器(下界)、平均服务器和平均服务器(上界)的基准线的基线不同。

图1:在不同进风温度下的服务器故障率

探索这些温度限制、阈值的动机是确定是否可以在没有冷却器或任何制冷剂冷却的情况下设计和操作数据中心。 因此,我们了解到,我们的供应温度不会是一个固定的设定点,而是在某些合理的范围内,采取某种形式的自由冷却来追随“大自然”。

例如,如果我们在明尼阿波利斯、法戈、夏威夷使用空侧节能装置,我们将在再循环混合箱中捕获足够的回流空气,以便在冬季将我们的最低温度保持在某一预定温度。

对于下面讨论的芝加哥博伊西的例子,我们不会让最低服务器进风温度低于59˚F(15℃),相当于A2类服务器的允许边界较低。 随着“X”(未知)因素的出现,ASHRAE提出了芝加哥的案例研究,因为每年在68˚ F(20℃)以下的小时数(其中数据中心将在59˚F和68˚F之间运行,采用自由冷却系统,没有 运行冷却器),服务器的可靠性实际上将比68°F巴西线提高3%,如下表2所示。

图2 :芝加哥的IT设备上,时间温度加权故障率计算

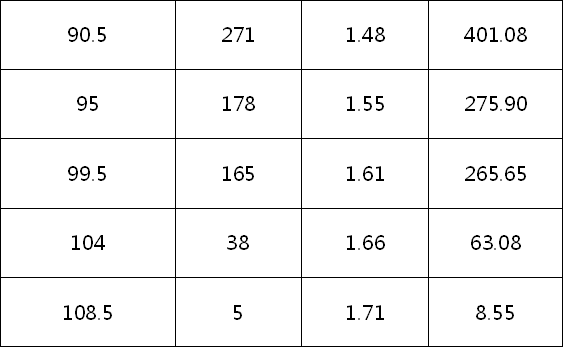

之前也为Boise的一个数据中心开发了一个类似的案例研究,它更详细地说明了实际因素是如何计算的。计算过程在表3中展开:

图3:对Boise服务器故障率的未知预测

总需求小时数等于7956小时,除以每年8760小时的IT可靠性预测估计为91%,这意味着在这些温度下运行数据中心的可靠性提高了9%,而数据中心全年运行温度为68⁰F(20℃)。

同样,除了节省某些形式的机械冷却的资本和运营费用之外,与数据中心相比,数据中心的服务器进风温度为68˚F(20℃),运行时间为24小时。 对于读者来说,我怀疑以前所有的讨论都只不过是标准的“X”(未知)因素分析,读者不要以为这个简单的工具只是拥有标准线,它还可以很好的应用于68˚F基线之外。

在最近遇到的一个项目中,就能看到未知因素在其他不同场合的实际应用。 在这家数据中心,在地板周围安装了差不多27个温度传感器,他们收集温度数据,读数显示温度范围在68˚F(20℃)到80.6˚F(27℃)之间,部分数据高于两者范围内,部分数据低于两者范围内。

数据中心运维人员担心这些差异可能如何影响了服务器的可靠性。 传感器每十分钟记录一次读数。

总共20,136小时的汇编在如图4,结果未知因子总共为21,671。 假设基准线为68˚F,我们就可以断定我们的服务器故障的温度有所上升。 然而,这个空间并不是68˚F的理论基线,实际基准为68-80.6˚F

图4:未知因素的实际应用

如果同样将20136小时除以68-80.6˚F范围内的四类数据,那么基线X因素实际上是27710,X因子比为1.38,或比基于测量的传感器数据的实际比值高28%。

因此,在一年12个月里,超过1090台服务器经历12次服务器故障,如果他们在设计温度范围内运行了一年,他们可能会看到15次失败。

很明显,这种方法缺乏绝对的精度,但是在这种情况下,温度传感器的数据可以替代预期的环境场景或实际环境场景中的进风温度,它可以提供一个有用的、相对数量级的一些保证。

最后,我所讨论的所有例子都很方便地支持这样的做法:允许一些较冷的自由冷却温度,以补偿偶尔出现的高温过度现象。很明显,情况并非总是如此。

例如,ASHRAE推出的X 未知因素可以将诸如旧金山,西雅图,波士顿,丹佛,洛杉矶和芝加哥这样的城市确定为不带冷却器的数据中心可以提升服务器的可靠性,而这些位置在全天候基准线上均为68˚F(20℃)。 而休斯敦,达拉斯,凤凰城和迈阿密等城市的未知因素将超过1.0,凤凰城和迈阿密超过1.25。这是否意味着这些地理区域不被排除使用无冷水装置之外呢?

是的,但可能不如你想象的那么多。 例如,考虑实际发生的影响,如果您在特定位置建立了一个没有机械冷却的数据中心,那么您将遇到20%的服务器故障。 这个数字意味着什么?

如果你有过运行4000台服务器的经验是,您通常会在一年内以68˚F的温度中看到10次故障,那么4000台服务器故障的数量将会增加2个,您可能希望根据与“ 更多的免费冷却时间,或者也许不包括在您的新数据中心的设计和建造中的冷水机组。

同样地,如果正常经验表明,期望在68˚F的温度内,7*24小时运行,会出现有3次失败,那么,如果失率增加的20%,需要花费2年的时间来产生额外的失败。这是一个商业决策。

当然,这是不言而喻的,除非我说的是:你的设计理念中包括了所有的气流管理的最佳做法,与此相反,如果有人采用此种设计方式,却对实施结果感到失望,那最有可能的罪魁祸首就是在实践中,对气流管理实践做的不够到位。

责任编辑:DJ编辑

评论表单加载中...

评论表单加载中...