| 摘要:如今,云计算的利用率有增无减。云服务的天下还是掌控在美国和中国几家自有超大规模数据中心的公司手中。在不久的将来, 云服务市场的业绩增长将主要得益于这些少数厂商, 因为许多企业已决定放弃自建数据中心,并将其应用程序迁移到云平台上。 |

如今,云计算的利用率有增无减。云服务的天下还是掌控在美国和中国几家自有超大规模数据中心的公司手中。在不久的将来, 云服务市场的业绩增长将主要得益于这些少数厂商, 因为许多企业已决定放弃自建数据中心,并将其应用程序迁移到云平台上。

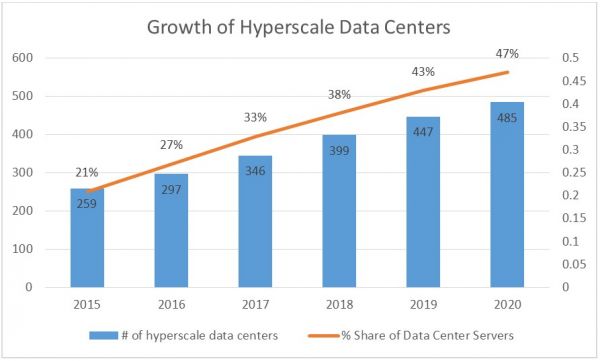

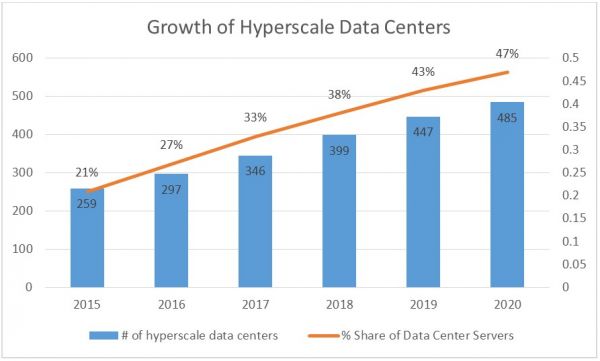

图1显示,到2020年超大规模数据中心的预期增长规模, 以及预期驻留在这些数据中心的服务器的百分比。到 2020年, 市面售出的服务器中预计将有47%被卖给了超大规模数据中心客户。

对于诸如 HPE 和 Dell 等传统硬件提供商, 这种情况则预示其客户群体变窄了,也意味着这些客户将具有更高的技术洞察力并密切关注着技术趋势。HPE 和戴尔将会发现,他们面向大规模数据中心客户的销售,将被一些没有名头的白箱供应商替代,后者可以满足客户的所需。显然,一台服务器配置已经不再包打天下了。开放计算,将日益成为降低成本和提高效率的重要途径。

图1 资料来源: Synergy Research研究机构发布的思科全球云2015–2020指数。

新的网络拓扑为超大规模数据中心通信量带来更高的带宽。Facebook 已经开放了其基于商品的交换机设计规范, 并向世界展示了SDN与网络功能虚拟化的诸多优势。

对于超大规模数据中心运营商来说, 在电力交付方面的创新以及新的冷却方法增加其设施中的机柜功率密度, 同时提高了整个基础设施的效能,产生极低的 PUE值。

什么是超大规模数据中心?

如今,超大规模数据中心已是威震八方,实际上它起源于上世纪八九十年代的互联网热潮。

微软因MS-DOS的火爆而成功蜕变成如今身价900亿美元的科技巨头, 其业务也从软件套装发展到 SaaS (Office 365) 与PaaS (Azure),这背后离不开其全球数据中心的布局;

1994成立的亚马逊公司则是从一家网上书店起家,如今成为身价逾1700亿美元的电子商务巨鳄, 同时也是世界上最大的云服务提供商;

Facebook 是全球最大的基于社交媒体发展而来的企业, 在全球拥有众多的大型数据中心。阿里巴巴则是中国本土的电商,对标美国亚马逊, 它正在扩大其数据中心的版图,并已走出了国界;

谷歌则起源于上世纪90年代的一个研究项目, 并迅速上升成为最大的互联网搜索提供商,该公司也同样依赖于分布在全球各地的海量数据中心,以满足所有人在进行网络搜索时对快速性能的需求。

与此同时,行业还有另外一些超大规模数据中心占有者,实现了快速增长,包括苹果、腾讯、百度和EBay。

大多数超大规模数据中心构建者都拥有自己的基础设施。最初由HPE、Dell EMC和思科生产的硬件支撑的超大规模数据中心运营商,正逐渐转向中国大陆和台湾地区的原始设备制造商,诸如广达、英华、纬颖科技、富士康、英业达、超微电脑与浪潮等,以寻求更为低廉的成本,更有针对性开放计算和网络解决方案。

功率密度和冷却系统对超大规模设计的影响

在过去的200年中,数据中心行业的机柜功率密度与计算、存储密度相当。如今,单一机柜中出现了越来越多的服务器和硬盘,同时采用的是横向扩展方式而不是扩展方式。一个典型的IT机柜的能耗曾是1-3千瓦,而现在机柜内常见的负载为20-40千瓦。美国国家可再生能源实验室则宣称,30千瓦的机柜如今已是十分普及。

据谷歌公司负责全球基础设施业务的Joe Kava透露,谷歌在2015年使用了5.7太瓦时的能源。卡瓦说:“数据中心的能耗占去了大半,这也是谷歌缘何能成为云计算园区可再生能源的头号买家。”

基于英特尔、AMD、Nvidia和Arm等巨头最新芯片技术的新服务器,每秒可提供前所未有的高运算速度和每瓦运作次数。与此同时,大多数市场中的数据中心地产成本持续上涨,导致运营商寻求更高的IT机柜,试图更有效地利用空间。这样一来,一排排满是IT设备的高大机架,不可避免地产生了散热问题。数据中心架构师必须尽早选择空气或水作为冷却介质。一些设施则同时部署两种方案。

高效的空气冷却系统需要遵守各种设计原则:

交替设备的方向,来创建天然冷通道或热通道。

在空机柜空间中使用盲板,以确保冷空气不会泄漏到热通道中。

采用热通道或冷通道遏制系统。

精心设计的设施中可实现空气的自然对流——冷空气下沉到地面,暖空气升到天花板。因此,对冷通道采用高架冷空气服务,并在机柜背面提升天花板或烟囱的高度,以达到在设备中对流的效果。

绝热冷却依靠通过体积膨胀引起的气压变化来减少热量的过程。绝热过程已被用于数据中心,以促进利用水和电的“自由冷却”方法。

当机柜功率和热密度超过以合理速度流动空气的冷却能力(高达几百CFM)时,液体冷却方式就派上了用场。液冷有多种形式:冷却门、冷板、直接喷雾冷却到芯片上等。

“在高性能计算领域,一切都将转向液冷,”Eurotech技术总监Paul Arts说道,“在我们的设想中,这是达到百万兆级的唯一途径。我们认为这才是新一代高性能计算的开始,潜力无限。如今只是在革命的最开始。”

最终,制冷系统的决策将取决于数据中心将运行的参数:硬件更换/修理的频率、可用技工的数量、可维修时间的长短、所需的电能效率水平等。

驱动未来需求

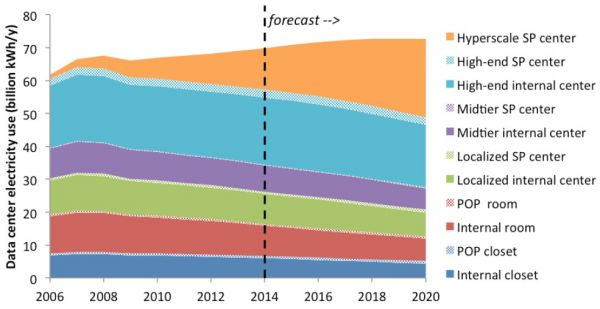

许多论文都记录了数据中心行业在21世纪初日益增长的电力需求。假如当初摩尔定律和服务器虚拟化没有影响数据中心行业的发展,电力总需求的增长可能会超出美国总产能的10%。所幸IT行业身先士卒,率先开启了节能减排,使IT系统变得更加节能。英特尔和AMD限制了每个服务器芯片(CPU)的功耗,而伴随着每代CPU的产生,厂商们又煞费苦心,一方面保持了现有包络功率,另一方面又改进了每个周期的指令,并减少了每条指令的功率。

图3.资料来源:美国能源部

展望未来的话,许多超大规模数据中心运营商正致力于为其设施提供可再生能源。首先,通过购买可再生能源证书(RECs),并采用补偿手段(从当地公用事业购买水力发电等绿色能源),许多超大规模数据中心如今都已采用燃料电池或太阳能板上现场生成的能源。例如,苹果和Facebook已经有多地的数据中心依靠太阳能板运行。微软在怀俄明州拥有沼气工厂,从Pilot Hill Wind购买风力发电;并在全球许多设施生成太阳能。亚马逊在德克萨斯州建立了一个253兆瓦的风力发电场,而谷歌从2017年起,让所有数据中心都用上可再生能源。“我们是全球最大的可再生能源的企业级买家,”Google技术基础设施高级副总裁Joe Kava说。

至于究竟哪种类型的电力基础设施最适合超大规模数据中心,整个IT行业众说纷纭。此前Facebook选择的是480V/277V交流电源的机柜以及IT负载12V直流电源的机柜。在最近对开放计算的贡献中, Google 建议 48V DC 为服务器供电,直接转换点负载电源48V,满足主板需要运行 CPU, 内存等组建所需的电压与电流。在 Google 的实践中, 从电源插座到机架的电源是 480/277V AC (或400 V /230 V AC), 电源架上将交流电源转换为直流电源的功率托架上有三相整流器。微软则采用了480/277V的机柜电源和277V 服务器。

对于那些试图通过发电设备运行数据中心的公司来说, 现场生产直流电源并传输到机架上是很有意义的。在这种情况下, 将 380V dc 带到机架上, 并将直流-直流转换器运行到48V 是一种选择。或者,它甚至可以将48V 带到机架上, 这取决于电源的距离。

每个数据中心都是为了实现功能性、时延性、运行时间、成本和价值目标而构建的,这些目标与电源传输基础设施密切相关,而电源传输基础设施将很大程度上影响到数据中心运行的软件栈的稳健性和灵活性。未来的超大规模数据中心很可能会从虚拟机转移到容器, 并提供 "无服务器" 计算模型。

关于交流与直流电源的争论将继续, 而新的技术, 如机架上的燃料电池将会越来越流行。未来,超大规模数据中心采用可再生能源,或将成为业主和运营商的强制性要求。

责任编辑;DJ编辑

评论表单加载中...

评论表单加载中...