| 摘要:随着企业数字化转型速度的加快,传统企业逐步开始适应云服务。据相关数据显示,2018年下半年,占比最大的IaaS(基础设施即服务)市场同比增长88.4%。全年市场规模(IaaS/PaaS/SaaS)首次突破70亿美元大关。这就使得作为云服务载体的数据中心发展也随之水涨船高。 |

随着企业数字化转型速度的加快,传统企业逐步开始适应云服务。据相关数据显示,2018年下半年,占比最大的IaaS(基础设施即服务)市场同比增长88.4%。全年市场规模(IaaS/PaaS/SaaS)首次突破70亿美元大关。这就使得作为云服务载体的数据中心发展也随之水涨船高。

除此之外,很多政企出于自身需求,也在不断建设自用数据中心。据统计,目前全国公共机构数据中心已经超过4万个。虽然这些数据中心对于社会经济的发展贡献极大,但其产生的能耗问题也令人侧目。目前,数据中心用电量占公共机构总用电量的比例已经达到8%左右,而中央国家机关数据中心用电量占比更是高达30%。

虽然耗电如此弥巨,但数据中心本身对所在地的税收贡献微乎其微。同时在运营方来看,耗电量占其数据中心整体运营成本的比重也并不很大,所以改造或者应用新技术去节约能源的动力不足。这就使得北,上,广,深等一线城市只能不断对数据中心加码严控。

在这种背景下,如何降低能耗,就成为了数据中心建设和运营方不得不考虑的问题。众所周知,空调系统是目前数据中心能耗的大户。尤其是对于夏天的南方各省来说尤甚。目前虽然液冷技术经过多年的发展已经取得了长足进步,但成本制约因素很大,在相同规模下,传统的液冷在建设成本比采用气冷方式的数据中心要高出15%-20%。况且全浸式液冷,还需要对建设场地的承重有较高要求。再加上需要专业团队进行长期运维,所以很难在近两年内形成优势。

笔者曾经走访过南方很多数据中心,虽然有少部分应用了一定的水冷技术,但主要还是以风冷为主。这些数据中心在机房内部密闭的空间里,通过冷风将服务器散发出来的热量带走。这种制冷方式的优点在于建设成本很低,但缺点是建设周期长,且能耗极高。

日前,笔者参观了中国移动南方基地,在这里见到了一种采用“热管水冷+空调/自然气冷”为核心技术的双通道散热系统。该系统“分而治之”的思路,或许能为我们降低数据中心能耗带来一些不错的启示。

中国移动南方基地内,应用双通道散热技术的微模块数据中心

目前数据中心从散热通道上来说,有单通道和双通道之分。前者是通过一种换热介质对IT设备进行冷却,这里面包括有单通道的气冷和液冷两种模式。但双通道的散热技术,则包括热管水冷、热管液冷、直接水冷。其特点是结合数据中心IT设备的热场特征,液冷通道对高热流密度元件进行精准散热,带走绝大部分热量,气冷通道对低热流密度元件进行高效散热,带走剩余热量。比如CPU还有其他的高发热、高热流密度元件可以采用这种精准的模式通过液冷散热。至于低热流密度的设备,则可以采用气冷模式,使用传统空调或者自然水进行散热。

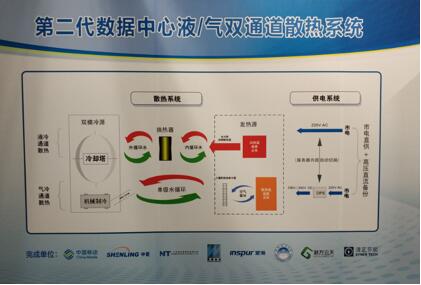

图为目前中国移动第二代双通道散热技术的工作流程图

和传统的气冷,浸没式液冷相比。这种散热技术在液冷通道采用“热管水冷”,在气冷通道采用“空调/自然气冷”;供电方面则是市电直接供应到服务器。和传统市电先到UPS,再到设备的方式相比,能有效消除转换损耗。除此之外,因为省去了冷水主机和50%的供电备份设备,同时功率密度提高后也相应降低了土建的支出,所以这种双通道散热技术的数据中心在建设成本方面,和目前采用传统气冷方式的数据中心基本相当。

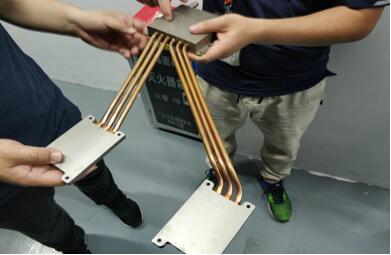

笔者注意到,在中国移动的机房内部,这种散热方式非常精妙。简单来说,就是用两根中空的散热铜管(热管),一端接在需要散热的元器件上方,另一端则接驳到服务器边缘的水冷板换热器处,当液体流经水冷板时会将散发的热量带走,然后经过换热器(板式换热器)进入冷却塔并进行循环,水冷板与板式换热器之间的水源也并无太高要求。使用中水即可。

图为服务器内部的液冷器件“热管水冷模块”,结构非常简单

至于那些低热流密度元件,则依然采用风冷。虽然并未完全摆脱空调,但由于主要热量已经被液冷系统带走,所以只需要极少的电力保持空调运转即可。并且,在该技术的第二代方案中,连气冷通道都取消了压缩机,整体散热系统能耗非常低,只需低容量的EPS即可在市电中断时维持散热能力,无需传统散热技术常用的大型蓄冷罐。

据中国移动南方基地的丘文博工程师介绍,液/气双通道散热技术由“工信部工业转型升级绿色制造项目”支持,经工信部组织的7位院士鉴定,达到国际领先水平。该技术可应用于各种类型数据中心,选址具有普适性。在效果方面,应用第一代双通道散热技术的数据中心,即使在高温高湿地区,也可实现PUE<1.2、单机架容量高达30kW、CPU内核温度≤54℃的不俗效果。同时,和第一代不同的是,中国移动正在测试的第二代技术,甚至可以直接利用自然冷却水,通过单体机柜封闭气流循环,实现“水/气换热”,将机柜内部的硬盘,内存等低热流密度元件发热量带走,整体PUE可以降低到1.1以下。

政府和业界对数据中心节能越来越重视,节能技术的发展也在加快,液冷技术将逐渐成为主流。目前对新技术的评价主要有能源利用率、资源利用率、安全可靠性、经济性、运维便利性、环境影响等维度。采用这种双通道散热技术的数据中心节能效果显著,资源利用率高,投资成本更低,更安全可靠。很适合新建数据中心,或者是具备改造条件的老旧数据中心。甚至在未来5G时代边缘数据中心大行其道以后,这种双通道散热方式也会有其不错的市场空间。

责任编辑:DJ编辑

评论表单加载中...

评论表单加载中...