●背板水冷系统

机柜背板采用先进的冷冻水盘管,每组背板可提供27kW冷量。

●冷量防损系统

高密度密闭空间,精确制冷。

●Free Cooling系统

采用冷冻水空调系统和FreeCooling,比风冷数据中心节电40%。

●智能消防系统

智能感应温感消防报警系统,极早期烟感报警系统(VESDA)和气体灭火系统,统一在OS平台报警,符合国家消防和机房建设标准。

●动态制冷系统

根据IT容量,动态调整制冷功率和流量,按需制冷。

●全面冗余系统

电源和散热全冗余,包括输送到机架的独立电源。

●IT系统管理

IT基础库与配置管理,优化系统性能。

云监控与网络连接管理KVM系统。

动力环境监控系统。

●云管理系统

虚拟化集中管理,一个平台管理所有虚拟设备。快速创建虚拟机,监控与配置均采用智能式管理。

模块化数据中心是未来数据中心发展的一个趋势,但同时也面临着不少的挑战,比如在机柜、配电、制冷、部署、运维、应用等方面。云箱作为天地云箱自主创新研发设计的模块化数据中心产品,又是如何设计的呢?

性能

·单机柜计算容量可达27KW

·PUE值可降至1.2-1.4

·可快速部署,周期为4-8周

·集成的监控管理模块可全面监控环境、动力、IT系统

·模块化UPS及模块化制冷系统,便于机房资源扩容

应用

·高性能计算

兼容多品牌服务器、网络及存储设备,可在一个20英尺长的集装箱内托管1000台服务器,支持分布式并行计算。

·公有云

建立分布式数据中心,支持各种类型的SaaS应用。

部署弹性云计算平台,支持按需分配和弹性调度资源。

·私有云

部署虚拟化数据中心,提供基础设施利用率,降低IT成本。

基于高可靠性数据中心,提供自服务器机制,实现业务应用精确交付。

数据中心工作组组长 钟景华

数据中心发展正走向第四代,以模块化、可扩展、高效、及时为特征,可在任何地方快捷地组建。模块化/集装箱数据中心具有快速、按需部署,节约能源,即插即用等特点,尤其适应云计算等应用需求。“云箱”的推出及其成功应用,为模块化/集装箱数据中心发展开创了一个新里程。

数据中心发展正走向第四代,以模块化、可扩展、高效、及时为特征,可在任何地方快捷地组建。模块化/集装箱数据中心具有快速、按需部署,节约能源,即插即用等特点,尤其适应云计算等应用需求。“云箱”的推出及其成功应用,为模块化/集装箱数据中心发展开创了一个新里程。

中国联通IDC副总经理 康楠

我们正在积极探索第四代云计算数据中心的技术和营运模式。云计算和绿色节能都是我们IDC产业发展的必然趋势。云箱的诞生彻底改变了数据中心建设周期长、一次性投入大、能源消耗高、扩展性差的现状,使客户在低投入的情况下,快速、弹性、绿色地部署IT资源并提供服务。

我们正在积极探索第四代云计算数据中心的技术和营运模式。云计算和绿色节能都是我们IDC产业发展的必然趋势。云箱的诞生彻底改变了数据中心建设周期长、一次性投入大、能源消耗高、扩展性差的现状,使客户在低投入的情况下,快速、弹性、绿色地部署IT资源并提供服务。

中国工程院院士 倪光南

从政府到企业到用户,大家都对云计算寄予很大的期望,云箱的出现,改变了过去数据中心的一些瓶颈,从下游到上游,至少对于整合北京的云计算全产业链,起到了很好的促进作用。云箱有自己的云服务器(超云服务器)、虚拟化软件、云计算平台,做到了在未来适应云计算基础设施的扩容及优化管理,这是很好的。

从政府到企业到用户,大家都对云计算寄予很大的期望,云箱的出现,改变了过去数据中心的一些瓶颈,从下游到上游,至少对于整合北京的云计算全产业链,起到了很好的促进作用。云箱有自己的云服务器(超云服务器)、虚拟化软件、云计算平台,做到了在未来适应云计算基础设施的扩容及优化管理,这是很好的。中国云计算专家委员会委员 杨扬

云计算在实践过程中还存在诸多问题,云箱的发布很好地解决了一个硬件基础设施的问题。从IaaS、PaaS和SaaS三个层面来看,相对而言,我国的SaaS与国外的差距不大。差距最大的是IaaS和PaaS,底层比较欠缺,今天云箱发布了,这为中国的IaaS建立了一个底层硬件基础,同时也表明中国的底层硬件设施在快速发展。

云计算在实践过程中还存在诸多问题,云箱的发布很好地解决了一个硬件基础设施的问题。从IaaS、PaaS和SaaS三个层面来看,相对而言,我国的SaaS与国外的差距不大。差距最大的是IaaS和PaaS,底层比较欠缺,今天云箱发布了,这为中国的IaaS建立了一个底层硬件基础,同时也表明中国的底层硬件设施在快速发展。

中国数据中心产业发展联盟秘书长 郑宏

通过测试并进行数据对比,云箱在特定领域下的应用在整体上的能源效率比传统的数据中心大大提高,PUE值可控制在1.3以下,云箱只需4-8周时间,即可部署完毕交付使用,相较于传统IDC,提高了近10倍速度。无疑,这对于中国的数据中心产业发展起到了促进作用,同时,云箱的发布具备了开创绿色数据中心新时代的意义。

通过测试并进行数据对比,云箱在特定领域下的应用在整体上的能源效率比传统的数据中心大大提高,PUE值可控制在1.3以下,云箱只需4-8周时间,即可部署完毕交付使用,相较于传统IDC,提高了近10倍速度。无疑,这对于中国的数据中心产业发展起到了促进作用,同时,云箱的发布具备了开创绿色数据中心新时代的意义。

北京天地云箱科技有限公司CEO 徐红忠

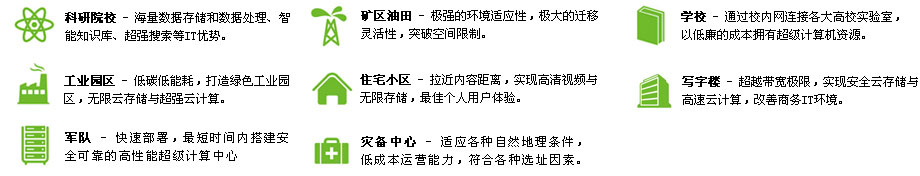

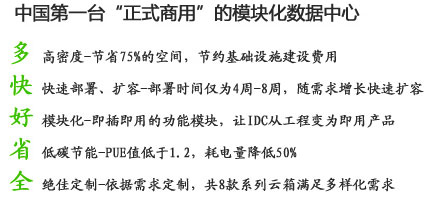

云箱的发布仅仅是我们实现研发生产云时代主机这个理想的一个开端,云箱的五大特性:多、快、好、省、全,是模块数据中心应用的一个实质性的突破。科研院校、工业园区、学校、写字楼、住宅小区、灾备中心、军队及矿区油田等用户,都可以根据具体的需求用云箱来部署。这同时体现我们“一切皆服务”的云时代服务理念。

云箱的发布仅仅是我们实现研发生产云时代主机这个理想的一个开端,云箱的五大特性:多、快、好、省、全,是模块数据中心应用的一个实质性的突破。科研院校、工业园区、学校、写字楼、住宅小区、灾备中心、军队及矿区油田等用户,都可以根据具体的需求用云箱来部署。这同时体现我们“一切皆服务”的云时代服务理念。

与传统数据中心相比,云箱模块化数据中心有着独特的优势,云箱可以实现比传统数据中心更高的计算密度,其单机柜计算功率为传统机柜的5 倍,从而可以节省75% 的空间。通过采用全封闭空间内的高效制冷技术,云箱能够极大缩短冷、热气流的路径,确保制冷量得到最充分的利用,从而使能源效率大大提高,PUE 值可降至1.3 以下。相较于传统数据中心,提供相同的计算功率,云箱耗电量可降低50%,极大降低了运营成本。下面以160KWIT负载为例,以下就能耗方面做一对比。[详细]

●传统IDC数据中心

单个机柜测试功率:4KW(功率密度约1KW/ ㎡)。

机架数(个)= IT负载÷单机柜功率 = 160(KW)÷4(KW) = 40(个)

占地面积(KW)= IT负载÷功率密度 = 160(KW)÷1(KW/ ㎡) = 160(㎡)

所需制冷量(KW) = 160+160×0.15=184(KW)

UPS容量 = 160KW /0.9/0.7=253kVA (0.9为功率因数,0.7为容量负载)

供配电损耗 = 253×10% = 25KW

数据中心总功耗(KW)= 制冷用电总负荷+供配电损耗+ IT 设备总能耗

根据以上数值,计算所得的总功耗为369KW,但还有其他的损耗,根据实际情况,范围值一般为:352~448。

那么,能源使用效率PUE = 数据中心总功耗÷ IT 设备总功耗 = (352~448)÷160 = 2.2~2.8。

●云箱模块化数据中心

云箱IT机柜除了MINI系和定制的外,均采用42U机柜,单个IT机柜的功率可达20kW(功率密度约为4KW/ ㎡)。

机架数(个)= IT负载÷单机柜功率 = 160(KW)÷20(KW) = 8(个)

占地面积(KW)= IT负载÷功率密度 = 160(KW)÷4(KW/ m2) = 40(㎡)

制冷用电总负荷 = 10KW – 80KW

UPS容量 = 160KW /0.9/0.7=253kVA (0.9为功率因数,0.7为容量负载)

供配电损耗 = 253× 8% = 20KW

数据中心总功耗(KW)= 制冷用电总负荷+供配电损耗+IT 设备总能耗

根据以上数值,计算所得的总功耗为190-260KW。能源使用效率PUE = 数据中心总功耗÷ IT 设备总功耗 = (190~260)÷160 =1.18~1.63

备注:PUE是一个数据中心能效比指标,PUE 越接近1.0 则表示数据中心效率越高。

北京云基地是由北京市经信委、亦庄开发区与宽带资本联合创建,旨在投资培育下一个信息技术制高点“云计算”的新兴产业基地。北京云基地目前投资企业9家,总投资金额5亿元。云基地各公司业务包含了云计算各个环节,包括分布式数据中心、云服务器、瘦终端、云存储等硬件产品;云操作系统、桌面虚拟应用系统等基础软件;智能知识库、数据挖掘系统等应用软件;以及云系统集成,整体构成了云计算产业链。云基地也与国际云计算厂家合作,引进先进云计算技术。

北京云基地是由北京市经信委、亦庄开发区与宽带资本联合创建,旨在投资培育下一个信息技术制高点“云计算”的新兴产业基地。北京云基地目前投资企业9家,总投资金额5亿元。云基地各公司业务包含了云计算各个环节,包括分布式数据中心、云服务器、瘦终端、云存储等硬件产品;云操作系统、桌面虚拟应用系统等基础软件;智能知识库、数据挖掘系统等应用软件;以及云系统集成,整体构成了云计算产业链。云基地也与国际云计算厂家合作,引进先进云计算技术。

云箱是北京天地云箱科技有限公司设计生产的集装箱式机房系列产品的统称,其利用集装箱为载体,在集装箱中放置机房运行环境所需的各种设备,比如动力设备、制冷设备、消防设备、监控设备等。

云箱整体采用了模块化的设计理念。模块化是指云箱由若干相互独立的模块构成,每个模块具备机房运行中的一个或多个系统功能,这些即插即用的功能模块通过简单组装就能构成完整的机房运行环境。