| 摘要:中国数据中心工作组专家组一行12人,踏上考察美国数据中心之路。在美期间,专家组考察了美国排名前三位的数据中心运营商Equinix、DRT、Cyrusone,以及Sabey、Switch、DFT等大型数据中心运营商的数据中心。 |

北京时间2016年8月20日中午,中国数据中心工作组专家组一行12人,踏上考察美国数据中心之路。在美期间,专家组考察了美国排名前三位的数据中心运营商Equinix、DRT、Cyrusone,以及Sabey、Switch、DFT等大型数据中心运营商的数据中心。

专家组成员简介:

钟总:中国数据中心工作组组长,研究员级高级工程师,中国电子工程设计院副总工程师,享受国务院专家津贴,国标《电子信息系统机房设计规范》主编。钟总是中国数据中心发展的带头人。

马总:中国数据中心工作组秘书长,此次考察的组织者,考察前与美国多个数据中心进行深入沟通,使考察中每次交流均获得高规格接待与详细讲解。

中国某超大型互联网公司的Z总和Y总,行业专家,引导和参与了多项数据中心新技术,推动了中国数据中心的发展。

中国某大型数据中心运营商的H总和L总,两位在数据中心选址、前期方案设计和选择、整体成本核算等方面都有非常丰富的经验。

中国某视频通讯公司数据中心部门的Y总,具备多年的数据中心的方案设计、建设、运维经验。

中国某数据中心领域设计院的W总,具备丰富的数据中心设计经验,参与多个数据中心的设计。

中国某超大型通信科技公司的A总,数据中心及数据中心空调系统专家,具备丰富的设计经验。

某国际电气公司美国总部的技术专家L总,具备丰富的数据中心设计经验,在整个考察过程中担负了沟通与翻译工作。

深圳市英维克科技股份有限公司的王铁旺、吴刚,中国数据中心工作组专家技术委员会委员,本文的作者。在此,作者也感谢以上十位专家在此文撰写中给予的帮助和指导!

此次考察的行程安排非常紧凑,包括作者在内的几位专家组成员未参加后半程考察,8月20日周六抵达美国,27日周六离开美国,8天时间先后飞行7次,参观了6个数据中心,其中几天,大家都是夜里只睡不到5小时,早起赶机场奔赴下一个地点考察。

回国后,作者对考察进行了回顾,并查阅了数据中心所在地气象资料等,对6个数据中心的制冷系统的考察情况进行总结,内容如下:

一、位于Quincy的Sabey数据中心,空调系统采用间接蒸发自然冷却+DX制冷补充

Washington州的Quincy位于Seattle东部约260公里。

Washington州位于美国西北部,西邻太平洋,具备以下适合建设数据中心的条件:

1.全年气候凉爽,适合数据中心利用自然冷却;

2.Columbia河带来丰富的水电资源(包括装机容量曾经世界第一,现在世界第三的Grand Coulee水电站),电价低;

3.土地成本较低;

4.地震、洪水、飓风等自然灾害很少发生;

5.距离太平洋西岸的国际通讯枢纽距离近,网络传输等有优势。

因此,Yahoo、Microsoft、Dell等知名企业在Washington州都建有数据中心。

图1:Quincy的数据中心分布

在Quincy的Sabey数据中心,Sabey公司的总裁JohnSabey,与副总裁Timm先生等,热情接待了专家团。

在JohnSabey的介绍中,我们获知,他的父亲于45年前创建了这家公司,70年代从事电信机房的建设,主要客户有Boeing、ADP(美国一家知名的财务公司)、AT&T,Starbucks等,1995年后随着互联网的发展,进入数据中心行业,承担设计、建设、运营数据中心业务,由建筑开发商成功转型为数据中心运营商。

目前共有5个大的数据中心,在Seattle和Quincy所在的Washington州有4个,在NewYork有1个(在一栋高层建筑中)。数据中心总面积达到30万平方米,总负载达到285MW,数据中心部分达到Tier3标准,但也有客户要求Tier1,按需提供。经营方面,零售与批发相结合,出租建筑空间与机柜相结合。针对部分客户,Sabey只提供建筑和市电接入,其它建设,完全由客户自己负责。

Sabey是美国前几位的大型数据中心,既吸引了Microsoft、T-mobile、Expedia等大公司的入驻,又吸引了Internap、Centurylink、Sawis这样的Colo客户。

Sabey Quincy数据中心的电价超低,只有0.0265美元/kWh。这么低的电价,原因有两点,一是Washington州的水电丰富,这里的Columbia河上建有4座水电站;二是政府对数据中心用电进行了优惠。

Sabey人员称,同样的1MW数据中心,在Quincy的全年运营电费为$278,500,而在San Francisco则为$1,778,280,也就是说,不到San Francisco的六分之一。

Sabey Quincy数据中心为新建数据中心,单平层结构,建筑层高7.2米,空调系统采用间接蒸发冷却,直接膨胀式(DX)制冷系统作为冷量补充。即空调系统具备三级冷却和制冷,第一级是干态间接自然冷却,第二级是喷淋间接蒸发冷却,第三级是直接膨胀式(DX)补充制冷。空调系统为模块化结构,安装在建筑楼顶,鉴于Sabey的经营模式,完全可以适应模块化建设的节奏和要求。

Sabey人员介绍,间接蒸发冷却空调机组自然冷却工作时间高达95%以上,全年只有不到5%的时间需要直接膨胀式(DX)系统补充制冷。其全年PUE只有1.16左右,PUE最高值为1.20左右。在数据中心两侧,各有2个大型蓄水罐,用于存储空调系统间接蒸发冷却喷淋用的备用水。

经查阅美国太空总署(NASA)气象数据库中22年的气象数据,Quincy全年的关键气象数据如下:

表1:Quincy全年关键气象数据表

可以看出,Quincy的冬、春、秋季温度较低,夏季昼夜温差较大,即使是晴天的最高温度时段,距离地表10米处的温度也比较低(这与我们当时的体验是一致的,虽然还是盛夏季节,在阳光下感觉较热,但在阴凉处感觉很凉爽),而且相对湿度较低,适合采用蒸发冷却技术。

图2:Sabey Quincy数据中心俯视图

图3:Sabey Quincy数据中心侧视图

二、位于Seattle的Sabey数据中心,空调系统采用直接蒸发自然冷却+CW制冷补充。

Sabey Seattle数据中心,在Seattle市区边缘,距离机场较近,是用1985年的老厂房改造而成。数据中心总共3层,1层全部是电源,包括发电机组、UPS、电池等,2楼和3楼是数据中心。空调系统采用直接蒸发冷却,冷水机组做为补充制冷。

图4:Sabey Seattle数据中心俯视图

作者非常好奇,为什么Sabey在Seattle市区的数据中心用直接蒸发冷却,而在远离城市的Quincy却用间接蒸发冷却?

Sabey技术人员说,Seattle数据中心所在位置的空气质量全年都很好,而Quincy周围有较多农田,那边农民某些季节会焚烧秸秆,空气质量就会有问题,所以在Quincy用间接蒸发冷却。

专家组部分成员内部讨论认为,Sabey在较老的数据中心中应用直接蒸发冷却技术后,不排除也会由于其控制复杂、空气湿度变化大不宜控制、运维工作量大等其它原因,因此在其新建的数据中心中应用了间接蒸发冷却,而不再是直接蒸发冷却。

技术人员介绍,Seattle数据中心全年PUE为1.3~1.4。全年只有2%~3%的时间开冷水机组,而且开冷水机组的主要目的并不是补充制冷,而是除湿。我们提出了我们的问题,就是全年绝大部分时间都是用自然冷却,为什么PUE还会比Quincy高?

Sabey技术人员回答说数据中心由老厂房改建的,直接蒸发冷却机组布置在数据中心的二层中央位置,回风、送风都接了很长的风管,风阻比较大,风机功率比较高,所以PUE比较高。

经查阅美国太空总署(NASA)气象数据库中22年的气象数据,Seattle全年的关键气象数据如下:

表2:Seattle全年关键气象数据表

可以看出,Seattle为沿海城市,全年温度较低,适合自然冷却。相对湿度略高。

图5:Sabey Seattle数据中心Google earth俯视图

三、位于Las Vegas的SUPERNAP数据中心,空调系统采用直接蒸发自然冷却+间接蒸发冷却+CW或DX制冷补充

Switch公司在Las Vegas的SUPERNAP数据中心,被很多业内专家评价为“全球最酷”,此次参观,的确是实至名归,比其网站图片上看到的还“酷”!

图6:SUPERNAP数据中心全景(图片来源于SUPERNAP官网)

Switch公司本身作为通信网络运营商,具备得天独厚的网络优势,有超过100家的通信运营商的网路接入,为超过98%的客户提供宽带接入服务。

SUPERNAP在Las Vegas的数据中心项目包括12个单元,已经运行和在建项目总面积2365838平方英尺(22万平方米),总供电容量超过325MW,全年平均PUE1.28,最低PUE1.08;专家组参观了其中一个单元,该单元包括超过7000个机柜,数据中心的温湿度传感器超过10000个;用电负荷为180MW,100%采用绿色能源,主要以太阳能发电为主;数据中心采用标准模块化部署,多个机柜为一组,背靠背排列,热通道采用隔板封闭,通道隔断外侧分三层布置强弱电缆。

图7:SUPERNAP数据中心内部机柜摆列方式(图片来源于SUPERNAP官网)

空调气流组织采用上送上回,标准化制造的送风单元组成送风支路,每个送风单元均配置了可调节风阀,按需供冷,精确送风,使得冷通道气流分布均匀,并降低风机能耗。

图8中,蓝色风管为送风支路风管,红色通道为回风通道。

图8:SUPERNAP数据中心的送风风管与回风通道(图片来源于SUPERNAP官网)

通过空调系统下部的制冷模块(即图6中空调模块的白色部分)送冷风至送风风管,通过送风风管均匀送风至冷通道,热通道回风通过回风通道导入数据中心的回风层,再送至空调系统上部的排风模块(即图6中空调模块的红色部分)。

图9:SUPERNAP数据中心的回风层(图片来源于SUPERNAP官网)

我们在现场,看到制冷系统6种模式的文字提纲介绍,但其技术人员并未做详细解释,我们分析如下:

模式1 —— 全新风自然冷却:即在室外干球温度、相对湿度及空气洁净度满足要求时,通过空调系统下部的制冷模块的新风风阀引入新风,新风过滤后进入数据中心冷通道,热通道热风通过空调系统上部的排风模块排到室外大气中;

模式2 —— 直接蒸发自然冷却:即在干球温度较高,湿球温度较低,空气洁净度满足要求时,通过空调系统制冷模块的新风风阀引入新风,新风经过过滤,进入空调系统的蒸发冷却段,通过直接蒸发冷却降低干球温度,进入数据中心冷通道,热通道热风通过空调系统排风模块排到室外大气中;

模式3 —— 新风回风混合模式自然冷却:即在干球温度较低、空气洁净度满足要求时,通过空调系统制冷模块的新风风阀引入新风,并与空调系统排风模块的部分回风混合,以确保送风温度不会过低(避免导致结露等问题),混合后进入数据中心冷通道,热通道热风部分参与混风,其余热风通过空调系统排风模块排到室外大气中;

模式4 —— 间接蒸发自然冷却:即在室外温度较低、空气质量不达标(包括风沙较大)的时段,空调系统制冷模块完全关闭新风阀,并完全打开空调系统排风模块的回风风阀,通过闭式冷却塔的间接蒸发冷却提供冷冻水,通过空调系统制冷模块中的冷冻水(CW)盘管对数据中心空气进行自然冷却,空气在数据中心内循环;

模式5 —— 直接膨胀式制冷:即在全新风自然冷却或间接蒸发自然冷却等状态下,当制冷量不足时,开启空调系统的直接膨胀式(DX)主机模块,利用空调系统制冷模块中的DX蒸发盘管,进行冷量补充;

模式6 —— 冷水机组冷冻水制冷:即在全新风自然冷却或间接蒸发自然冷却等状态下,当制冷量不足时,开启空调系统的冷冻水式(CW)制冷单元,即空调系统制冷模块中的CW盘管的冷源由冷水机组提供,进行冷量补充。(此模式为选配,仅在 Switch的部分的数据中心配置)。

图10:SUPERNAP数据中心的空调系统(图片来源于SUPERNAP官网)

针对以上6种冷却与制冷模式分析,以及数据中心的冷热通道布局等,我们通过调阅SUPERNAP的专利,进行了确认。

以下为其专利文件上的部分图示:

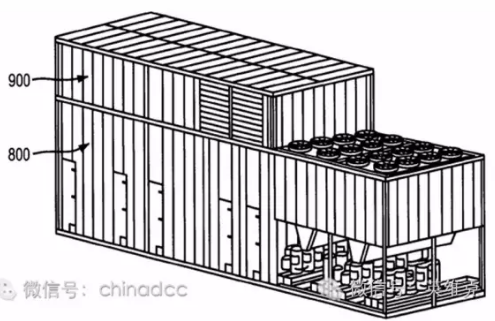

图11:SUPERNAP专利中图示-数据中心及空调系统布局(图片来源于SUPERNAP专利文件)

图11中:800指空调系统的制冷模块;900指空调系统的排风模块;591指空调系统的间接蒸发冷却模块;590指机柜模块

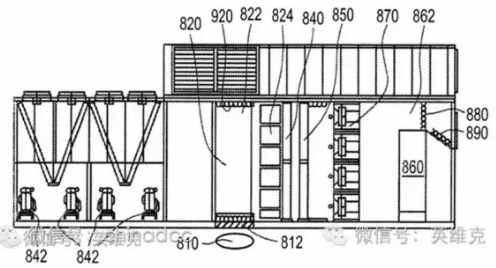

图12:SUPERNAP专利中图示-数据中心及空调系统、送回风管路、机柜(图片来源于SUPERNAP专利文件)

图12中:310指冷通道送风风管;210指热通道回风通道

图13:SUPERNAP专利中图示-数据中心及空调系统、送回风管路(图片来源于SUPERNAP专利文件)

图14:SUPERNAP专利中图示-数据中心制冷系统(图片来源于SUPERNAP专利文件)

图15:SUPERNAP专利中图示-数据中心空调系统(图片来源于SUPERNAP专利文件)

图15中:842指空调系统制冷模块的的压缩机;824指空调系统制冷模块的空气过滤器段;840指空调系统制冷模块的直接膨胀(DX)制冷系统的蒸发盘管段;850指空调系统制冷模块的间接蒸发系统的CW盘管段;870指空调系统制冷模块的风机墙段;860指空调系统制冷模块的蒸发冷却段

SUPERNAP的空调系统智能化程度高,每个数据中心单元的机柜上有多个温湿度传感器和压差传感器,通风系统有多个风阀控制器,通过温度和冷热通道压差控制空调送风系统的风量,实现精确制冷和节能运行。

现场,SUPERNAP的专家演示了机柜进风温度改变,风阀自动调整的过程。其自主研发的环控系统、设备监控系统,使数据中心处于自动、节能的运行状态。

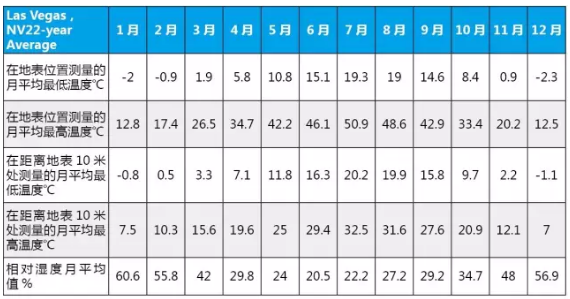

经查阅美国太空总署(NASA)气象数据库中22年的气象数据,LasVegas全年的关键气象数据如下:

表3:Las Vegas全年关键气象数据表

可以看出,LasVegas地处沙漠地区,虽然夏季时干球温度高,但相对湿度很低,特别适合蒸发冷却,也就是充分利用干湿球温差进行自然冷却。SUPERNAP针对沙漠地区针对性地设计了的空调系统,实现了低PUE值,值得学习。

图16:地处沙漠地区的SUPERNAP数据中心

四、位于Dallas市区的DRT数据中心,空调系统采用乙二醇自然冷却双盘管

DRT公司是美国第二大的数据中心运营商。DRT公司的全称是Digital Realty,其在全球4大洲14个国家经营着156个数据中心,随着DRT在全球业务的开展,这个数字还在持续更新中。其虽然只有11年的历史,但目前市值已经高达140亿美金。

位于Dallas市区的数据中心为高层建筑,这座大楼原来归属于TelX公司,TelX公司为包括DRT在内的公司提供网络接入服务,并擅长分散业务及运营商的数据中心零售业务,后来Texl公司被DRT公司收购。

图17:DRT Dallas数据中心Google earth俯视图

参观中我们看到,此数据中心的主要功能为其多个数据中心提供网络接入、网络交换等,此数据中心的运营时间也比较长,因此采用的机柜摆放方式、制冷方式相对传统:没有封闭冷通道和热通道;上送风风帽送风,前回风;回风温度较低,24℃左右。

制冷方式采用乙二醇自然冷却双盘管:因这个数据中心高达20层以上,管路距离成为选择制冷方式的主要限制因素之一,又希望采用具备自然冷却功能的制冷系统,因此乙二醇自然冷却双盘管空调是很好的选择,低温时段可以关闭压缩机,通过干冷器实现自然冷却;高温时段,压缩机开启,通过干冷器散热。原理如图18。

图18:乙二醇自然冷却双盘管机房专用空调原理图

五、位于Dallas近郊Richardson的DRT数据中心,空调系统采用直接自然冷却+DX制冷

Richardson距离Dallas市区约30公里,这个DRT的数据中心规模较大。

图19:DRT数据中心

交流中主要讨论了DRT数据中心的建设和运营的思路,了解到DRT更为重视数据中心的设计过程,甚至,设计过程长达20~52星期。而在基础设施产品方面,DRT坚持模块化思路,模块化空调系统等基础设施产品,可在60天内完成生产,并迅速实施建设,这样不但可以保证产品与系统质量(系统在工厂完成大部分调测工作,而不是在现场调测),而且可以极大缩短建设与系统调测时间。

图20:DRT数据中心俯视效果图

在电价方面,此数据中心的电价低至0.04美元/kWh。

机柜租售方面,费用分两部分:

1.机柜电功率及对应面积,可计算得出基本的费用;

2.机柜的实际电费及数据中心的PUE值,可计算得出每月实际发生的电费。

因此,DRT的客户也会更加关注该数据中心的PUE值,关注自然冷却,因为与其费用密切相关。

此数据中心建筑采用2层结构,1层为供电系统,2层为数据中心,空调系统全部布置在楼顶屋面,采用直接新风自然冷却+DX制冷,冷空气直接送入数据中心地板下,地板高度为3英尺(0.91米),下送风(参观中,看到其中一个数据中心单元的通风地板上,摆了一个“星球大战”中黑武士的公仔,黑色披风随着地板下送风飘扬,可直观感受房间的风量,很有意思),通过天花回风至建筑屋面的空调系统。

数据中心并没有封闭冷通道和热通道,因此回风温度较低,在24℃左右。

如图21与图22所示,数据中心每个单元按3+1配置空调系统,空调机组布置在屋面上。 电气房间的空调形式也是一样,只是空调系统的制冷量要小一些。

图21:DRT数据中心模块化设计布局图

图22:DRT数据中心模块化设计屋顶效果图

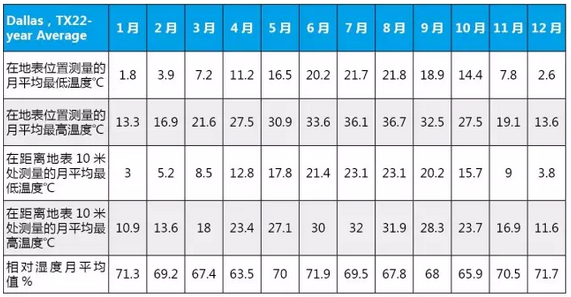

经查阅美国太空总署(NASA)气象数据库中22年的气象数据,Dallas全年的关键气象数据如下:

表4:Dallas全年关键气象数据表

可以看出,Dallas地处美国南部,温度和湿度相对较高,DRT设计直接新风自然冷却,以保证PUE值足够低。由于Dallas全年相对湿度有并不低,这可能是DRT只采用直接新风,而没有采取直接蒸发冷却的主要原因。

六、位于Dallas近郊Carrollton的CyrusOne数据中心,空调系统采用风冷冷水机组+冷却塔自然冷却

CyrusOne公司是美国第三大的数据中心运营商。CyrusOne公司在世界各地拥有并经营34个数据中心。该公司通过大规模模块化架构实现了快速扩张,该公司曾用短短的107天在凤凰城建立了自己的第二家数据中心,充分体现了其快速建设的能力。

图23:CyrusOne数据中心

位于Dallas的数据中心位于Carrollton,距离Dallas约15公里。该数据中心原为半导体厂房,层高高达10米,该机房采用冷冻水机房专用空调,下送风,地板高度约1米。上回风。

图24:CyrusOne数据中心内部(图片来源于CyrusOne官网)

制冷主机采用风冷冷水机组。自然冷却设计为:春、秋、冬季等低温时段,利用开式冷却塔和板换做冷冻水的降温预冷,串联在系统中,水先经过板换,如果水温达到数据中心供水温度要求,则冷水直接进入数据中心,否则预冷后再进冷机进一步冷却。

以上是对作者考察的6个数据中心制冷系统的总结,此次考察收获非常大,思考与总结如下:

1.美国的数据中心,即使在电价非常低(Sabey数据中心电价低至0.0265美元/kWh,DRT数据中心电价低至0.04美元/kWh)的情况下,制冷系统仍会重点设计自然冷却,以减少数据中心运营费用。与之相比,国内某些地区的电价虽然已经优惠至0.4元人民币左右,但与美国比较,还是较高,应该更加重视自然冷却;

2.美国的数据中心,在制冷方式的设计和选择上非常灵活,选用多种模式,因地制宜,因气候条件制宜,因空气质量制宜;

3.美国的新建数据中心,空调系统倾向于模块化空调机组,空调机组在工厂内预制和调试好,适合分期建设和快速建设,并可以确保产品与系统的交付质量;

4.美国的新建数据中心的模块化空调系统,设计在数据中心屋面和侧面的情况都有。设计在屋面的,如Sabey的间接蒸发冷却空调系统与直接蒸发冷却空调系统,DRT的直接新风自然冷却空调系统等。SUPERNAP数据中心的混合式蒸发冷却空调系统,设计在建筑室外的一侧。

5.美国的数据中心空调系统设计,更加重视TCO(OPEX与CAPEX)的分析,我们判断部分数据中心的空调系统造价较高,但其更为重视OPEX带来的连续收益;

6.美国的新建数据中心,较少设计有地板,通常采用封闭冷热通道的方法。

另外需要注意的是,中国数据中心借鉴其制冷系统设计方法时,必须综合考虑气候条件,尤其是大气质量,中国大部分地区的全年大部分时间的空气中的硫化物超标,必须慎重选择直接自然冷却系统。如果选择了直接自然冷却系统,必须通过合理的设计实现在空气质量不好的时段,隔绝数据中心室内外空气,并综合考虑成本。

一周考察时间很快结束,专家团大部分成员继续考察美国东部Equinix、DFT、DRT等大型数据中心(并会持续在ChinaDCC公众号上发布考察成果),包括作者在内的几位成员先行回国。

特别撰写此文,与读者分享此行的收获和感想,文中难免出现记录与分析错误之处,欢迎读者斧正。

在此也特别感谢中国数据中心工作组的精心组织和悉心安排,虽然行程紧张、舟车劳顿,但学习到非常多的东西,大开眼界,作者也坚信此次考察会极大促进中国数据中心的发展!

版权声明:本文为作者原创,版权归中国数据中心工作组及深圳市英维克科技股份有限公司所有。欢迎转载,转载需注明版权归属,并保持原文完整。

责任编辑:DJ编辑

评论表单加载中...

评论表单加载中...